本文及资源最后更新时间 2021-07-16 by sky995

INFO-SPIDER

一个神奇的工具箱, 拿回你的个人信息.

Introduction

开发者回忆录🌈

点击展开👉 开发者回忆录🌈

场景一

小明一如往常打开 Chrome 浏览器逛着论坛,贴吧,一不小心点开了网页上的广告,跳转到了京东商城,下意识去关闭窗口时发现 (OS:咦?京东怎么知道我最近心心念念的宝贝呢?刚好我正需要呢!),既然打开了那就看看商品详情吧 (OS:哎哟不错哦),那就下单试试吧!

场景二

小白听着网易云音乐的每日推荐歌单无法自拔 (OS:哇!怎么播放列表里都是我喜欢的音乐风格?网易云音乐太棒了吧!深得我心啊!黑胶会员必须来一个!),逛着知乎里的“如何优雅的XXX?”,“XXX是怎样一种体验?”,“如何评价XXX?” (OS:咦?这个问题就是我刚好想问的,原来早已有人提问!什么???还有几千条回答!!进去逛逛看!)

场景三

小达上班时不忘充实自己,逛着各大技术论坛博客园、CSDN、开源中国、简书、掘金等等,发现首页的内容推荐太棒了(OS:这些技术博文太棒了,不用找就出来了),再打开自己的博客主页发现不知不觉地自己也坚持写博文也有三年了,自己的技术栈也越来越丰富(OS:怎么博客后台都不提供一个数据分析系统呢?我想看看我这几年来的发文数量,发文时间,想知道哪些博文比较热门,想看看我在哪些技术上花费的时间更多,想看看我过去的创作高峰期时在晚上呢?还是凌晨?我希望系统能给我更多指引数据让我更好的创作!)

看到以上几个场景你可能会感叹科技在进步,技术在发展,极大地改善了我们的生活方式。

但当你深入思考,你浏览的每个网站,注册的每个网站,他们都记录着你的信息你的足迹。

细思恐极的背后是自己的个人数据被赤裸裸的暴露在互联网上并且被众多的公司利用用户数据获得巨额利益,如对用户的数据收集分析后进行定制的广告推送,收取高额广告费。但作为数据的生产者却没能分享属于自己的数据收益。

想法

如果有一个这样的工具,它能帮你拿回你的个人信息,它能帮你把分散在各种站点的个人信息聚合起来,它能帮你分析你的个人数据并给你提供建议,它能帮你把个人数据可视化让你更清楚地了解自己。

你是否会需要这样的工具呢? 你是否会喜欢这样的工具呢?

基于以上,我着手开发了 INFO-SPIDER 👇👇👇

Why INFO-SPIDER

- 个人数据蕴含巨大的价值, 未来的世界核心就是数据, 这是一个万亿级的市场. 众多的公司利用用户数据获得巨额利益, 如对用户的数据收集分析后进行定制的广告推送, 收取高额广告费. 但作为生产数据的最终用户, 却没能分享属于自己的数据收益.

- 个人数据分散在各种各样的公司之间, 经常形成数据孤岛, 多维数据无法融合. 很多优秀的创业公司, 被极大限制. 有算法、有创新,但缺乏合法且高效的途径访问数据.

- INFO-SPIDER 项目旨在提供最全的工具帮助用户安全快捷的从数据寡头拿回自己的数据, 自由选择提供给数据需求方, 挖掘自己数据的金矿, 分享自己数据的价值.

What is INFO-SPIDER

要想实现个人数据资产化, 如何拿回自己的数据是第一步, 一些数据寡头已经开始提供工具能让用户自由导出数据, 如谷歌公司, 已经提供方式让用户下载自己的数据.

这是一个好的开始, 但还不够, 还有很多公司没有提供官方工具或者只能下载很有限的数据. 而目前市面上的数据获取工具要么数据源不全, 要么不开源不透明. 无法保证工具本身不会偷偷窃取用户的数据, 甚至用户的用户名和密码.

INFO-SPIDER 旨在安全快捷的帮助用户拿回自己的数据,工具代码开源,流程透明。并提供数据分析功能,基于用户数据生成图表文件,使得用户更直观、深入了解自己的信息。

Features

- 安全可靠:本项目为开源项目,代码简洁,所有源码可见,本地运行,安全可靠。

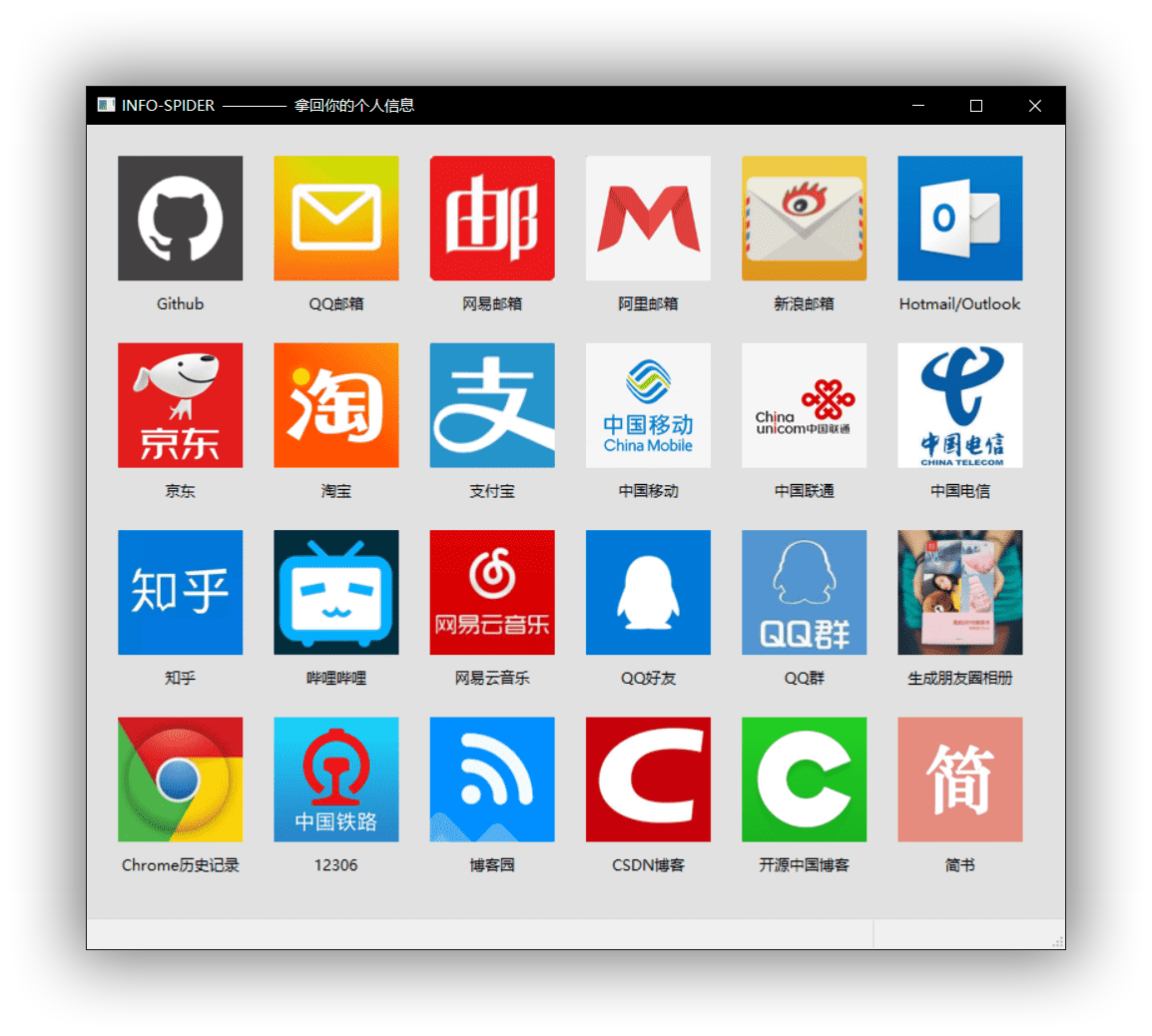

- 使用简单:提供GUI界面,只需点击所需获取的数据源并根据提示操作即可。

- 结构清晰:本项目的所有数据源相互独立,可移植性高,所有爬虫脚本在项目的Spiders文件下。

- 数据源丰富:本项目目前支持多达24+个数据源,持续更新。

- 数据格式统一:爬取的所有数据都将存储为json格式。

- 个人数据丰富:本项目将尽可能多地为你爬取个人数据,后期数据处理可根据需要删减。

- 数据分析:本项目提供个人数据的可视化分析,目前仅部分支持。

- 文档丰富:本项目包含完整全面的使用说明文档和视频教程

Screenshot

QuickStart

依赖安装

- 安装python3和Chrome浏览器

- 安装与Chrome浏览器相同版本的驱动

- 安装依赖库

./install_deps.sh(Windows下只需pip install -r requirements.txt)

目前该工具箱仅在Windows环境下正常运行, 还未在Linux/MacOS环境下进行测试, 后续更新会兼容多平台.

工具运行

- 进入 tools 目录

- 运行

python3 main.py - 在打开的窗口点击数据源按钮, 根据提示选择数据保存路径

- 弹出的浏览器输入用户密码后会自动开始爬取数据, 爬取完成浏览器会自动关闭.

- 在对应的目录下可以查看下载下来的数据(xxx.json), 数据分析图表(xxx.html)

👍 每个数据源的爬取可能会生成多个文件, 所以建议为每个数据源新建一个文件夹来保存数据.

数据分析功能还在开发中,暂时只支持部分数据源